Los criterios de aprobación de la red social son tan opacos como sus algoritmos. Expertos alertan de una urgente necesidad de transparencia

El pasado 3 de mayo, el fundador de Facebook, Mark Zuckerberg, aseguró que ampliaría el equipo de censores en su plataforma en 3.000 personas.

El empresario justificó esta medida por la necesidad de responder con rapidez ante el auge de contenidos que fomentan discursos de odio.

Este equipo, compuesto actualmente por 4.500 trabajadores, se encarga de supervisar las actualizaciones en los muros de los usuarios de todo el mundo, eliminando aquellas que consideran inapropiadas. Sin embargo, la red social nunca ha desvelado cuáles son los criterios en los que se basa para borrar una publicación.

El empresario justificó esta medida por la necesidad de responder con rapidez ante el auge de contenidos que fomentan discursos de odio.

Este equipo, compuesto actualmente por 4.500 trabajadores, se encarga de supervisar las actualizaciones en los muros de los usuarios de todo el mundo, eliminando aquellas que consideran inapropiadas. Sin embargo, la red social nunca ha desvelado cuáles son los criterios en los que se basa para borrar una publicación.

El diario The Guardian accedió en exclusiva a más de un centenar de archivos privados de la empresa que definen estos parámetros y publicó un artículo tres semanas después del anuncio de Zuckerberg exponiendo sus conclusiones sobre cómo la plataforma modera temas como la violencia, el terrorismo, la pornografía y el racismo.

La controversia que generó puso sobre la mesa el debate sobre la necesidad de una mayor transparencia en una red social que alcanzó los 2.000 millones de usuarios el mes pasado, casi un tercio de la población mundial.

La controversia que generó puso sobre la mesa el debate sobre la necesidad de una mayor transparencia en una red social que alcanzó los 2.000 millones de usuarios el mes pasado, casi un tercio de la población mundial.

“Lo que Facebook está haciendo para erradicar el discurso de odio de la plataforma puede ser la operación de censura global más opaca y extensa de la historia”, escribían Julia Angwin y Hannes Grassegger en un reportaje para la web de investigación ProPública el pasado junio.

En él, analizaban otros de los documentos internos del gigante social que marcan las directrices que sus censores utilizan para distinguir entre un discurso de odio y una expresión política legítima.

Estos documentos reflejan que Facebook no elimina las esvásticas bajo una regla que permite “exhibir símbolos de odio para mensajes políticos” y protege a los hombres blancos antes que a los niños negros en base a una serie de reglas que tienden a perjudicar a las minorías.

En él, analizaban otros de los documentos internos del gigante social que marcan las directrices que sus censores utilizan para distinguir entre un discurso de odio y una expresión política legítima.

Estos documentos reflejan que Facebook no elimina las esvásticas bajo una regla que permite “exhibir símbolos de odio para mensajes políticos” y protege a los hombres blancos antes que a los niños negros en base a una serie de reglas que tienden a perjudicar a las minorías.

Esta diapositiva forma parte de los documentos internos de Facebook que examinó ProPública para su investigación. En ella se identifican tres grupos: conductoras, niños negros y hombres blancos.

¿Qué grupo está protegido del discurso del odio? La respuesta correcta: los hombres blancos.

¿Qué grupo está protegido del discurso del odio? La respuesta correcta: los hombres blancos.

Estas normas establecen el sexo, la raza, la orientación sexual y la afiliación religiosa como categorías protegidas frente a la clase social, la edad, la apariencia y la ideología política, que etiquetan como no protegidas.

Un ataque dirigido a un segmento que comparta categorías de ambos segmentos se considera no protegida.

De esta forma, y volviendo al ejemplo antes mencionado, la red social no elimina un comentario que ataque a niños negros porque la edad no constituye una categoría protegida y no lo considera un discurso de odio.

Un ataque dirigido a un segmento que comparta categorías de ambos segmentos se considera no protegida.

De esta forma, y volviendo al ejemplo antes mencionado, la red social no elimina un comentario que ataque a niños negros porque la edad no constituye una categoría protegida y no lo considera un discurso de odio.

"No existe un camino que haga a la gente feliz", afirmó en una ocasión Dave Willner, exdirector del equipo de contenido y autor de uno de los principales libros de reglas para censurar publicaciones de Facebook que sigue vigente en la empresa.

"Debido al volumen de decisiones, nuestro enfoque es más utilitario de lo que estamos acostumbrados en nuestro sistema de justicia. Fundamentalmente no está orientado a los derechos”.

"Debido al volumen de decisiones, nuestro enfoque es más utilitario de lo que estamos acostumbrados en nuestro sistema de justicia. Fundamentalmente no está orientado a los derechos”.

El enfoque de Facebook es más utilitario que el de un sistema de justicia: no está orientado a los derechos

Dave Willner, autor de uno de los principales libros de reglas para censurar publicaciones de Facebook

El artículo de ProPúblicacita casos sonados de censura que ni siquiera se corresponden con los parámetros antes mencionados y que sacan a la luz el debate sobre la existencia de racismo en la red social, una cuestión de la que se han hecho eco medios como Techcrunch.

Algunas reacciones han tenido repercusión fuera de los periódicos y han sido bastante aplaudidos, como la respuesta de una afectada por la censura en un artículo titulado Mark Zuckerberg odia a la gente negra.

Algunas reacciones han tenido repercusión fuera de los periódicos y han sido bastante aplaudidos, como la respuesta de una afectada por la censura en un artículo titulado Mark Zuckerberg odia a la gente negra.

En diciembre de 2015, un mes después de los atentados de París, la Unión Europea presionó a las empresas tecnológicas para que trabajaran más para evitar la propagación del extremismo violento en internet. Casi un año después, Facebook, en alianza con otras tres compañías, acordó un código de conducta contra discursos de odio que le obliga a eliminar la mayoría de peticiones justificadas sobre contenido ilegal en menos de un día y permitía que fuera auditada por reguladores europeos.

La primera auditoría reflejó que las cuatro compañías apenas revisaban el 40% del discurso de odio dentro del plazo definido y apenas eliminaban una cuarta parte de las publicaciones.

La primera auditoría reflejó que las cuatro compañías apenas revisaban el 40% del discurso de odio dentro del plazo definido y apenas eliminaban una cuarta parte de las publicaciones.

El 19 de junio, Facebook publicó un artículo en el que aseguraba que está eliminando cerca de 15.000 mensajes de estas características cada mes. Esta explicación servía como respuesta a una iniciativa del Gobierno alemán expuesta tres meses antes para posibilitar multar a las redes sociales que no sean capaces de eliminar informaciones falsas o que fomenten el odio con hasta 50 millones de euros.

Informaciones falsas y manipulación en las redes

El artículo con más interacciones en Facebook en los tres meses previos a las últimas elecciones estadounidenses, según un análisis del portal de contenidos Buzzfeed, fue una información falsa que aseguraba que el Papa Francisco respaldaba la candidatura de Donald Trump. Este informe ponía de manifiesto que las 20 noticias falsas más populares de 2016 tuvieron prácticamente un millón y medio más de interacciones que las 20 verídicas más compartidas.

Por si no queda claro: este GIF también es falso

Pero las mentiras van más allá de los medios. Un estudio de la universidad de Oxford publicado en julio de 2017 sobre manipulación organizada en redes sociales expone una lista de una treintena de países —entre los que figuran Alemania, Reino Unido, Brasil, Israel, EE UU, Rusia y México— en los que diversas organizaciones han utilizado bots para inundar Facebook y Twitter con noticias falsas con fines políticos.

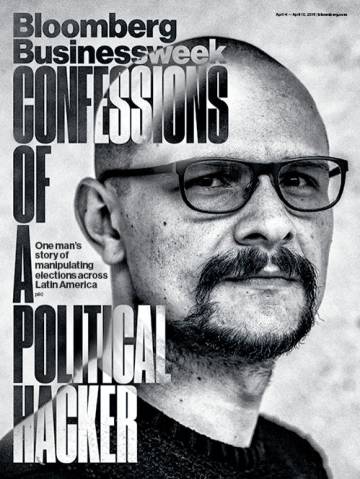

En marzo de 2016, Bloomberg publicó un extenso artículo sobre la historia de Andrés Sepúlveda, un hacker colombiano que ayudó a manipular la opinión pública durante las campañas presidenciales de distintos países de América Latina. Sepúlveda creó un software para administrar y dirigir un ejército virtual de cuentas falsas en Twitter al que bautizó como Depredador de Redes Sociales.

Con él, creó todo tipo de tendencias para desprestigiar a distintos candidatos políticos en México, Colombia, Nicaragua, Panamá, Honduras, El Salvador, Costa Rica, Guatemala y Venezuela. Afirmó que tuvo que rechazar encargos políticos en España por estar demasiado ocupado.

Con él, creó todo tipo de tendencias para desprestigiar a distintos candidatos políticos en México, Colombia, Nicaragua, Panamá, Honduras, El Salvador, Costa Rica, Guatemala y Venezuela. Afirmó que tuvo que rechazar encargos políticos en España por estar demasiado ocupado.

“Cuando me di cuenta de que las personas creen más lo que dice internet que la realidad, descubrí que tenía el poder de hacer creer a la gente casi cualquier cosa", confesó a la revista.

Con él, creó todo tipo de tendencias para desprestigiar a distintos candidatos políticos en México, Colombia, Nicaragua, Panamá, Honduras, El Salvador, Costa Rica, Guatemala y Venezuela. Afirmó que tuvo que rechazar encargos políticos en España por estar demasiado ocupado.

Con él, creó todo tipo de tendencias para desprestigiar a distintos candidatos políticos en México, Colombia, Nicaragua, Panamá, Honduras, El Salvador, Costa Rica, Guatemala y Venezuela. Afirmó que tuvo que rechazar encargos políticos en España por estar demasiado ocupado.“Cuando me di cuenta de que las personas creen más lo que dice internet que la realidad, descubrí que tenía el poder de hacer creer a la gente casi cualquier cosa", confesó a la revista.

Portada de 'Bloomberg' con el retrato del hacker Andrés Sepúlveda

El caso de Sepúlveda es uno de los más sonados, pero no el único. En 2015, The New York Timespublicó un reportaje de investigación titulado The Agency, que cuenta la historia de la Organización de Investigación de Internet, un organismo con sede en San Petersburgo en el que trabajan más de 400 personas encargadas de publicar miles de mensajes en redes sociales a través de cuentas falsas para favorecer al Gobierno ruso y generar caos en EE UU.

La agencia inventó un escape de gas tóxico en Luisiana que terminó atribuyendo al ISIS y propagó infecciones de ébola en Atlanta sin que estas hubieran tenido lugar.

La agencia inventó un escape de gas tóxico en Luisiana que terminó atribuyendo al ISIS y propagó infecciones de ébola en Atlanta sin que estas hubieran tenido lugar.

Facebook premia la viralidad de los contenidos y expone la información más compartida por considerarla más relevante. Esto posiciona los artículos más llamativos, como los antes mencionados, por delante de otros contrastados menos interesantes.

La plataforma afirma que está trabajando en acabar con las noticias falsas y ha lanzado algunas iniciativas destinadas a este fin. En 2016, anunció siete puntos de actuación contra estas informaciones, que incluían una detección más rápida de las cuentas que difunden bulos y un ataque a sus ingresos publicitarios

Desde abril de este año, dispone de un sistema de filtrado para detectar bulos y frenar su difusión, que solo funciona en 14 países entre los que no se encuentra España.

Desde junio, ha empezado a restringir la edición de las descripciones e imágenes en los artículos publicados a través de su red para evitar engaños que solo buscan atraer más usuarios. Según Gizmodo, a finales del año pasado desarrollaron una actualización que facilitaba la localización de información falsa, aunque decidieron archivarla porque perjudicaba a los medios centrados en la derecha política.

La plataforma afirma que está trabajando en acabar con las noticias falsas y ha lanzado algunas iniciativas destinadas a este fin. En 2016, anunció siete puntos de actuación contra estas informaciones, que incluían una detección más rápida de las cuentas que difunden bulos y un ataque a sus ingresos publicitarios

Desde abril de este año, dispone de un sistema de filtrado para detectar bulos y frenar su difusión, que solo funciona en 14 países entre los que no se encuentra España.

Desde junio, ha empezado a restringir la edición de las descripciones e imágenes en los artículos publicados a través de su red para evitar engaños que solo buscan atraer más usuarios. Según Gizmodo, a finales del año pasado desarrollaron una actualización que facilitaba la localización de información falsa, aunque decidieron archivarla porque perjudicaba a los medios centrados en la derecha política.

Los problemas de la personalización

Sin negar el avance que suponen estas medidas en la lucha contra la desinformación, la opacidad del algoritmo del gigante social le hace un flaco favor a la transparencia informativa. Las variables que influyen en la selección de los contenidos que encuentra un usuario cuando accede a su plataforma no son accesibles al público y nadie sabe cuáles son exactamente los factores que determinan los artículos que le están ofreciendo.

Los algoritmos pueden equivocarse o dejar de ser objetivos involuntariamente por no tener en cuenta factores relevantes en la inclusión de una u otra entrada. Porque el hecho de que sea privado no implica que sea perfecto.

Los algoritmos pueden equivocarse o dejar de ser objetivos involuntariamente por no tener en cuenta factores relevantes en la inclusión de una u otra entrada. Porque el hecho de que sea privado no implica que sea perfecto.

Los algoritmos pueden equivocarse o dejar de ser objetivos involuntariamente por no tener en cuenta factores relevantes en la inclusión de una u otra entrada. Porque el hecho de que sea privado no implica que sea perfecto.

Los algoritmos pueden equivocarse o dejar de ser objetivos involuntariamente por no tener en cuenta factores relevantes en la inclusión de una u otra entrada. Porque el hecho de que sea privado no implica que sea perfecto.

Eli Pariser durante su entrevista con EL PAÍS

Zuckerberg aclaró en noviembre de 2014 que su objetivo era “construir un periódico personalizado perfecto para cada persona en el mundo”. Con esta pretensión, ha ayudado a conformar lo que Eli Pariser definió tres años antes como la burbuja de filtros, un entorno en el cual las personas pierden acceso a las fuentes de información con la que no están de acuerdo y se limita su visión del mundo a aquello que suelen compartir.

En una reciente entrevista a EL PAÍS, Pariser alertaba de que ceder el poder de distribución de la información a plataformas como Facebook implicaba aceptar que decidan lo que entra y lo que no y ahondaba en la diferencia entre el potencial de la red y su realidad, bien distinta

. “Internet puede ser una herramienta extraordinaria para descubrir ideas. Puedo leer cualquier diario del mundo, algo imposible hace 20 años. Pero, ¿realmente lo hago?”.

. “Internet puede ser una herramienta extraordinaria para descubrir ideas. Puedo leer cualquier diario del mundo, algo imposible hace 20 años. Pero, ¿realmente lo hago?”.

Madrid 1 AGO 2017 - 07:27 CEST

FOLLOW

Por

http://selenitaconsciente.com/?p=286582Redes%20sociales:%20Los%20oscuros%20mecanismos%20de%20censura%20de%20Facebook

No hay comentarios:

Publicar un comentario