¿Cómo habría sido Terminator si Skynet hubiera decidido que probablemente no era lo suficientemente responsable como para tener las llaves de todo el arsenal nuclear de Estados Unidos? Resulta que los científicos pueden habernos salvado de un futuro apocalipsis liderado por la inteligencia artificial al crear redes neuronales que saben cuándo no son confiables.

Estas redes neuronales de aprendizaje profundo están diseñadas para imitar el cerebro humano al sopesar una multitud de factores en equilibrio entre sí, detectando patrones en masas de datos que los humanos no tienen la capacidad de analizar.

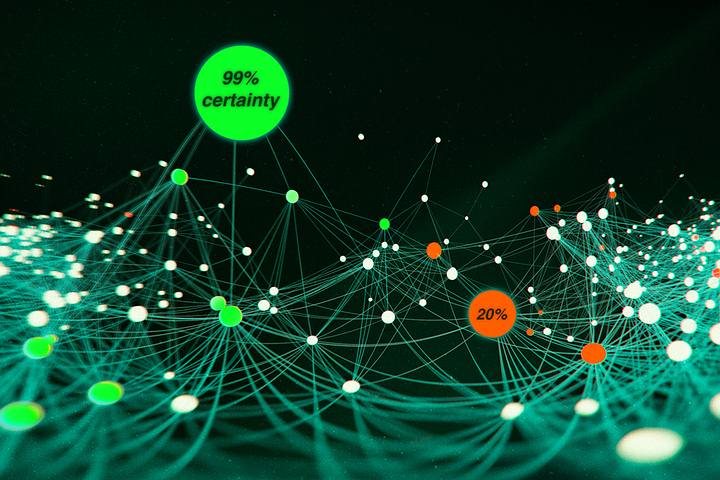

Si bien Skynet aún puede estar un poco lejos, la IA ya está tomando decisiones en campos que afectan la vida humana, como la conducción autónoma y el diagnóstico médico, y eso significa que es vital que sean lo más precisos posible. Para ayudar a lograr este objetivo, este sistema de red neuronal recién creado puede generar su nivel de confianza, así como sus predicciones.

«Necesitamos la capacidad no solo de tener modelos de alto rendimiento, sino también de comprender cuándo no podemos confiar en esos modelos», dice el científico informático Alexander Amini del Laboratorio de Ciencias de la Computación e Inteligencia Artificial del MIT (CSAIL).

A esta autoconciencia de la confiabilidad se le ha dado el nombre de «Regresión Profunda Basada en Evidencia», y basa su puntuación en la calidad de los datos disponibles con los que tiene que trabajar: cuanto más precisos y completos son los datos de entrenamiento, más probable es que las predicciones futuras van a funcionar.

El equipo de investigación lo compara con un automóvil autónomo que tiene diferentes niveles de certeza sobre si debe pasar por un cruce o si debe esperar, por si acaso, si la red neuronal tiene menos confianza en sus predicciones. La calificación de confianza incluso incluye consejos para aumentar la calificación (modificando la red o los datos de entrada, por ejemplo).

Si bien se han incorporado protecciones similares en las redes neuronales antes, lo que distingue a esta es la velocidad a la que funciona, sin demandas informáticas excesivas: se puede completar en una ejecución a través de la red, en lugar de varias, con un nivel de confianza generado al mismo tiempo que una decisión.

«Esta idea es importante y aplicable en general», señala la científica informática Daniela Rus. «Puede utilizarse para evaluar productos que se basan en modelos aprendidos. Al estimar la incertidumbre de un modelo aprendido, también aprendemos cuánto error esperar del modelo y qué datos faltantes podrían mejorarlo».

Los investigadores probaron su nuevo sistema haciéndolo juzgar las profundidades en diferentes partes de una imagen, al igual que un automóvil autónomo podría juzgar la distancia. La red se comparó bien con las configuraciones existentes, al tiempo que estimó su propia incertidumbre: los momentos en los que estaba menos seguro eran, de hecho, los momentos en que se equivocaban en las profundidades.

Como beneficio adicional, la red pudo marcar los momentos en que encontró imágenes fuera de su ámbito habitual (muy diferente a los datos en los que había sido entrenado), lo que en una situación médica podría significar que un doctor re-examine y eche una segunda mirada.

Según el escenario, incluso si una red neuronal tiene razón el 99 por ciento de las veces, ese 1 por ciento faltante puede tener graves consecuencias. Los investigadores dicen que están seguros de que su nueva prueba de confianza optimizada puede ayudar a mejorar la seguridad en tiempo real, aunque el trabajo aún no ha sido revisado por pares.

«Estamos empezando a ver muchos más de estos modelos (de redes neuronales) salir del laboratorio de investigación y entrar en el mundo real, en situaciones que están afectando a los humanos con consecuencias potencialmente mortales», comenta Amini.

«Cualquier usuario del método, ya sea un médico o una persona en el asiento del pasajero de un vehículo, debe ser consciente de cualquier riesgo o incertidumbre asociados con esa decisión».

La investigación se presentará en la conferencia NeurIPS en diciembre y un artículo está disponible en línea en el sitio del MIT.

Fuente: ScienceAlert. Edición: MP.

No hay comentarios:

Publicar un comentario