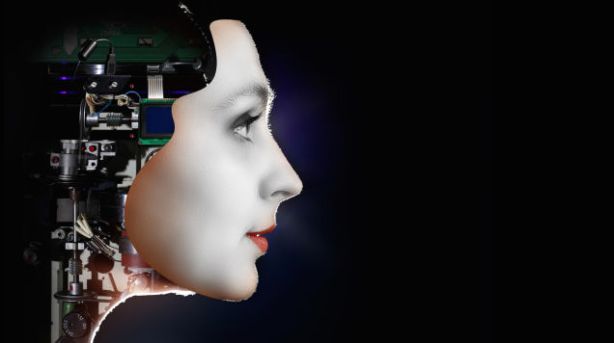

LAS PREVISIONES MÁS ASOMBROSAS (Y PREOCUPANTES) SOBRE LA INTELIGENCIA ARTIFICIAL

Un futuro en el que las máquinas sean tan inteligentes como los hombres es algo que la humanidad ha soñado e imaginado durante décadas. Personas como Ada Lovelace o Alan Turing, pioneros de la informática moderna, ya fantasearon con algo así.

Pero ¿cuáles son las implicaciones reales de “crear” inteligencia?

Los esfuerzos y la visión de Turing y Lovelace fueron clave en la invención durante el siglo XX de los primeros ordenadores. A los suyos se unieron los de otros como Gordon Moore, Robert Noyce, John von Neumann o Tim Berners Lee y muchos más. El de todos en su conjunto hace que ahora que despega el siglo XXI nos encontremos ante un abismo, cada vez más cercano e inmediato, en el que las máquinas serán mejores que el hombre en la única que el hombre ha hecho mejor que el resto de especies en el planeta: pensar.

Cuando las máquinas gobiernen la Tierra

Antes de seguir es interesante definir exactamente qué entendemos como inteligencia artificial. En su nivel más básico, la realidad es que la inteligencia artificial no es algo esencialmente nuevo.

Uno de los mejores ejemplos es el que miles de personas llevan en sus muñecas y bolsillos con asistentes como Siri, Cortana o Google Now. Una inteligencia artificial,

Deep Blue, fue también la que en 1996 derrotó por primera vez a un ser humano, Gary Kasparov, jugando al ajedrez.

Pero tanto Siri y similares o Deep Blue, aunque son capaces de superar y mejorar a la inteligencia humana en ámbitos muy concretos no lo son globalmente. Tampoco “piensan” en el sentido auténtico de la palabra ni son capaces de generar pensamientos o ideas a menos que hayan sido programados para ello. Tampoco tienen una consciencia, simplemente no ejecutan tareas mejor que nosotros.

Sobre esa inteligencia en un ámbito concreto, irónicamente lo cierto es que los seres humanos tampoco somos superiores en ese sentido, y cuanto más avanza la humanidad menos parecen serlo.

Dicho de otro modo: durante todo el siglo XX, el grado de especialización y de complejidad en las diversas disciplinas técnicas y científicas creció de manera tan acelerada que provocó un cambio progresivo desde un modelo con “grandes inventores” (Edison y la bombilla, Gutenberg y la imprenta) a otro donde las grandes invenciones surgen en realidad de un esfuerzo colaborativo. Internet y el smartphone son buenos ejemplos, no hay un inventor claro y definido, aunque sí haya figura claves que a su vez se nutren de avances y mejoras anteriores a ellos.

Lo mismo ocurre con la comunidad científica y médica: muchos avances son o bien realizados en conjunto o bien se apoyan en descubrimientos anteriores. Es lógico al fin y al cabo, cuanto más aumenta la especialización, más díficil es para el ser humano ser experto globalmente. Surge así el concepto de “Superinteligencia”. Una superinteligencia se define a menudo también como “

Probablemente la última cosa que el ser humano necesite inventar”.

Un futuro apasionante y preocupante, al mismo tiempo

Una superinteligencia domina varias áreas y además las domina por igual. La presencia de una tecnología así probablemente multiplicase los avances en otras áreas muy distintas. Es además, capaz de ser replicada (y potencialmente replicarse a sí misma), autónoma, con consciencia, capaz de aprender y por tanto de ser cada vez más poderosa. Una superinteligencia es puro intelecto,y no está atada tampoco a las afecciones más pasionales y sentimentales del ser humano.

Eso no es necesariamente “malo”. En realidad, uno de los principales problemas cuando afrontamos e imaginamos la inteligencia artificial somos, irónicamente, nosotros mismos. Imaginamos las máquinas como una proyección mecanizada del propio ser humano. Y probablemente no sea el modelo más inteligente a seguir.

La ciencia-ficción ha tratado el tema de manera equivocada

Una máquina no tiene por qué tener la psique humana y por tanto no tiene por qué sentirse incómoda siendo un esclavo que sirva a la humanidad (como sí se sentiría un humano, obviamente). Para bien o para mal, las máquinas no necesitan compartir nuestra emociones ni nuestros sentimientos.

Partiendo de esa base, la mayoría de argumentos de ciencia ficción, comenzando por Terminator, no tendrían demasiado sentido. Una máquina no tiene por qué sentir un impulso de superioridad, por ejemplo, o un concepto intrínseco de raza que le lleve a “sublevarse”. La cuestión es que en el momento en el que se entra a hablar de probabilidades, como es el caso, y de un futuro más bien ambiguo es normalmente porque todavía pertenece, para bien o para mal, a la ciencia-ficción.

Que no acabe de estar del todo claro, sin embargo, no significa que no tenga que haber una genuina preocupación en torno a cómo vamos a manejar la inteligencia artificial. La creación de esa superinteligencia probablemente sea un evento comparable al de la imprenta, el descubrimiento de américa o el propio internet. Y lo más delicado, como mencionaba antes, probablemente no ocurra sin más y de golpe, sino como consecuencia de unas invencinoes previas.

Conexión humano-máquina: cerebros en la nube

De esas invenciones, las más inmediatas en el horizonte son el coche autónomo de Google, que ya ha comenzado a funcionar y todo tipo de conexiones humano-máquina. Para 2030, una de las personas que mejor predijo el comienzo del siglo XXI desde los 90,

Ray Kurzweil, ha vaticinado algún

tipo de conexión cerebral entre humanos y la nube, eso permitiría no sólo “subir” información mental a la misma sino también nutrirse de manera casi inmediata de todo su conocimiento. Su libro,

La era de las máquinas espirituales, un título parcialmente basado en una definición de Ada Lovelace, es una gran lectura para entender y ampliar esto.

Stephen Hawking también avisaba hace poco sobre el potencial inmediato y

los peligros que una superinteligencia podría ocasionar. Para Hawking, lo preocupante no es si inicialmente somos capaces de controlarla, algo que se da prácticamente por sentado, sino si podremos hacerlo a largo plazo cuando y evitar que esa superinteligencia se vuelva contra nosotros.

Figuras como

Elon Musk, o Bill Gates, han realizado donaciones millonarias y gestiones a diversos fondos para favorecer que esa futura inteligencia artificial se convierta en algo beneficioso para la humanidad, en lugar de algo peligroso. Para intentar manejar de la manera más precisa posible ese cuchillo de doble filo.

Los dilemas éticos que plantea

Esa superinteligencia no será una persona, pero podrá realizar acciones al mismo nivel que una real. Y lo más importante: muchas de ellas lo hará mejor. Eso plantea algunos dilemas éticos interesantes.

Uno de los clásicos y más populares es aquel que plantea un coche capaz de frenar y ajustar su velocidad para salvar la vida tanto de peatones como de pasajeros. En un momento determinado, se encuentra en la particular situación en la que si frena bruscamente conseguirá salvar la vida de 5 personas en un paso de peatones a unos metros por delante, si lo hace, con todo, volcará matando al único pasajero en su interior. ¿Qué debería hacer el coche, no frenar y salvar la vida de 1 persona o hacerlo y salvar la de 5 seres humanos pero no la de su legítimo dueño? Es una pregunta delicada, con dimensiones éticas muy complejas pero que da a pie a otra más interesante ¿Cómo codificaremos las máquinas para que nunca se vuelvan contra la humanidad?

Con una superinteligencia el principal dilema es que el ser humano se enfrentaría, por primera vez en su historia, a algo que es exponencialmente más inteligente que él. Toma un poco de tiempo entender las dimensiones reales de la paradoja, pero las consecuencias pueden ser aterradoras.

La guerra contra las máquinas

Hay una gran variedad de niveles intelectuales en el ser humano, desde superdotados a gente rematadamente idiota, pero todos nos movemos dentro de un abanico lo suficientemente estrecho como para que el entendimiento sea común. Imaginemos ahora cómo nos ve, por ejemplo, un chimpancé, o un gorila, incluso un delfín.

La diferencia en coeficiente intelectual no es “tan” elevada, pero a nivel práctico somos esencialmente dioses. Resulta curioso comparar cómo verá el hombre a un máquina capaz de superarlo intelectualmente en múltiplos cada vez mayores. Y lo mejor: capaz de aprender y ser cada vez más avanzada.

Esa superinteligencia, como exponen las hipótesis de

Nick Bostrom, podría volverse en algún momento tan superior que acabe suponiendo la extinción del ser humano. No por un deseo de hacer el mal, en sí, sino porque no seamos capaces realmente de manejarlas o de pararlas.

Futuro incierto. Futuro apasionante. Futuro aterrador.

Aquí entra otro concepto interesante: la explosión de la inteligencia. Hasta ahora, y pese a los avances técnicos derivados fundamentalmente de la progresión de la Ley de Moore el principal limitante ha sido irónicamente la propia inteligencia humana. Pero, ¿qué ocurrirá cuando una máquina adquiera el suficiente nivel de inteligencia como para aprender del entorno y replicarse a sí misma? Ese es el concepto que recoge la

singularidad. A partir de la singularidad, el crecimiento y el avance de la inteligencia artificial vendrá determinado por la propia inteligencia de la máquina creando más máquinas, no por la del ser humano.

El

trabajo de personas como Ray Kurzweil y Vernor Vinge se ha centrado durante años en elucubrar sobre qué ocurrirá en el momento en el que aparezca la singularidad. Su conclusión: no lo sabemos. Cuando ocurra las posibilidades pueden propulsar a la raza humana hasta límites y extremos que nunca antes ha alcanzado o pueden condenarla a la extinción. Y hasta que esa singularidad no ocurra, la Inteligencia Artificial seguirá siendo apasionante y escalofriante a partes iguales.

https://libertaliadehatali.wordpress.com/2015/07/03/las-previsiones-mas-asombrosas-y-preocupantes-sobre-la-inteligencia-artificial/